通过站长工具重新评估恶意软件站

发表者:原文:Malware reviews via Webmaster Tools

发表于: 2007年8月13日,星期一,12:27PM

在过去的一年里,受流氓/恶意软件感染的网站数目从每周几个增长到每周数千。在我们以前的帖子“关于恶意软件警告”以及“停止恶意软件讨论组”里,我们听到了一些你们的建议,也就是改善我们与被感染网站的站长的交流。现在,我们的站长工具可以重新评估感染恶意软件的网站。

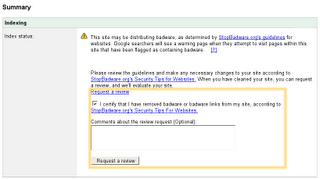

通过我们对搜索结果加上"恶意软件“标记,或是在站长工具里对你网站的一个总的概括,你可能发现你的网站感染了恶意软件。我们现在已经简化了审查程序,使Google在你的网站时去掉”恶意软件"的标签:

- 在站长工具里看一看你的感染了恶意软件的URL的样本。

- 根据StopBadware.org网站的安全提示对你的网站作出必要的改动。

- 新做法:使用站长工具要求Google重新评估你的网站。 我们会检查你的网站还有没有恶意软件。

- 新做法: 你可以检查我们重新评估的状态。

- 如果我们觉得你的网站仍是有害的,我们会提供你的危险URL的最新名单。

- 如果我们确认你的网站已经是正常了,你可以期待我们很快(通常是24小时以内)清除关于你的网站有恶意软件的信息。

我们鼓励所有站长去熟悉Stopbadware的恶意软件预防小技巧。如果你有其他问题,请阅读我们的相关文献或在讨论组上发帖。我们希望您觉得这个在站长工具中的新功能是有用的,特别是对发现和修正任何和恶意软件相关的问题。我们也对你们为认识和预防恶意软件的努力表示感谢。

我们鼓励所有站长去熟悉Stopbadware的恶意软件预防小技巧。如果你有其他问题,请阅读我们的相关文献或在讨论组上发帖。我们希望您觉得这个在站长工具中的新功能是有用的,特别是对发现和修正任何和恶意软件相关的问题。我们也对你们为认识和预防恶意软件的努力表示感谢。Labels: badware, Google Webmaster Tools, Google站长工具, 恶意软件

网站抓取、收录及SEO相关

网站抓取、收录及SEO相关